PVE虚拟化平台(2)Proxmox VE 节点网络冗余及内外分离配置

前言

虚拟化节点作为承载虚拟化业务的核心基础设施,其网络稳定性直接影响上层所有虚拟机的网络服务质量。为提高节点网络的可用性,采用基于active-backup模式的网卡冗余方案:通过双网卡绑定形成主备链路(业务网络与管理网络共用),主用网卡(active)承担全部流量传输,备用网卡(backup)实时待命,当检测到主链路故障时可实现秒级切换,有效保障关键业务不中断。

同时为应对集群迁移场景下可能出现的突发流量冲击,特别增设第三块独立物理网卡专门承载集群通信流量,通过物理隔离实现业务流量、管理流量与集群流量的多通道传输。此架构在确保网络高可用的同时,通过流量分流策略避免了不同类型流量间的相互干扰,既满足故障场景下的快速恢复要求,又能支撑高负载场景下的带宽需求,形成具备弹性扩展能力的网络架构。

- 网络简易架构图

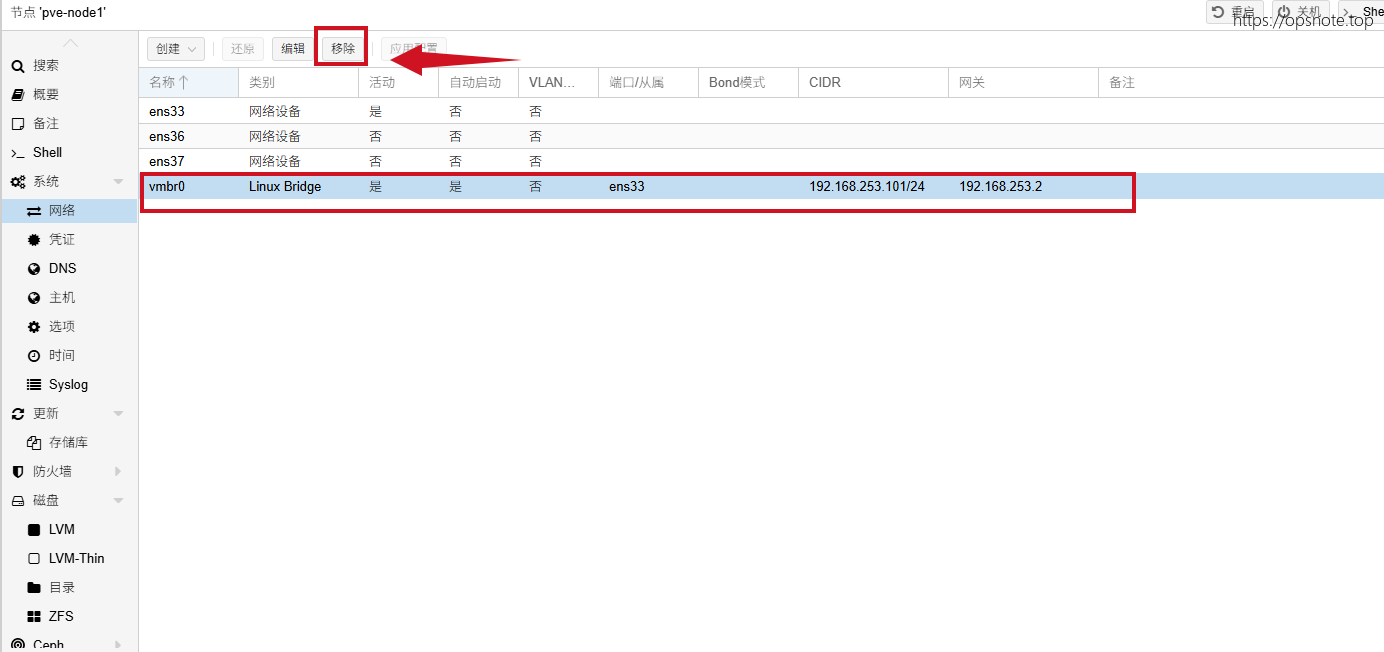

1. 移除旧网卡

移除网卡不点“应用配置”是不会生效的,所以不用担心点击移除后无法连接控制台的问题

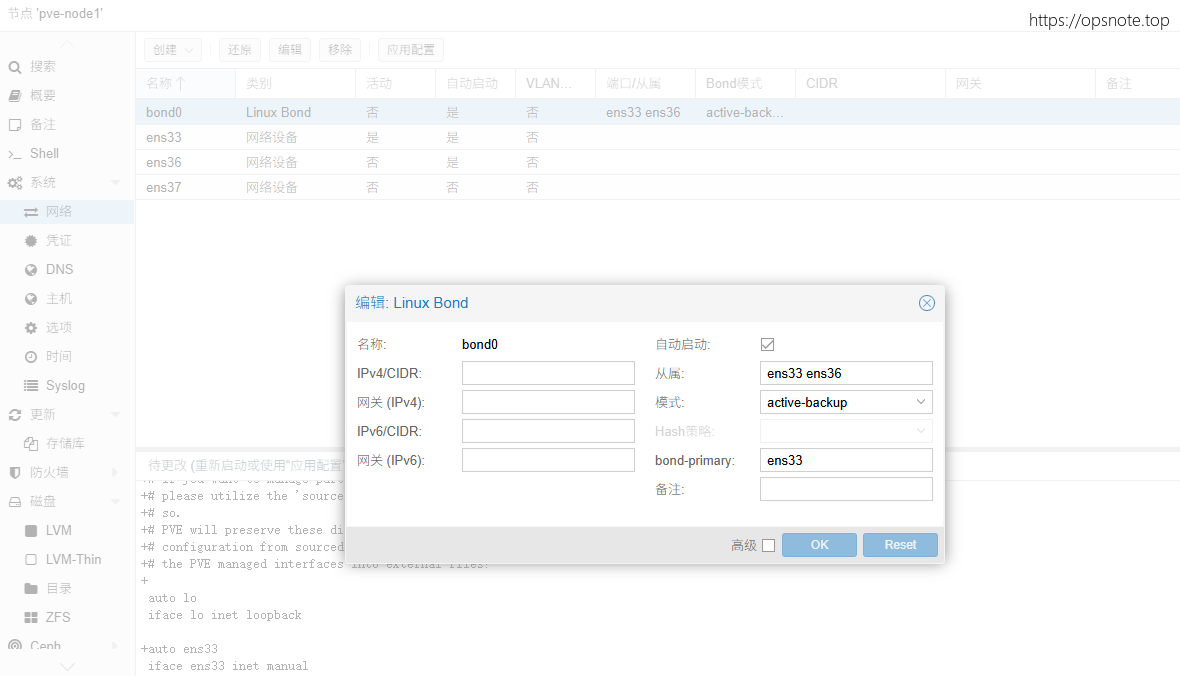

2. 创建bond0网卡

创建 Linux Bond,使用active-backup模式,bond网卡从属ens33网卡和ens36网卡,设置ens33为活动接口(active)

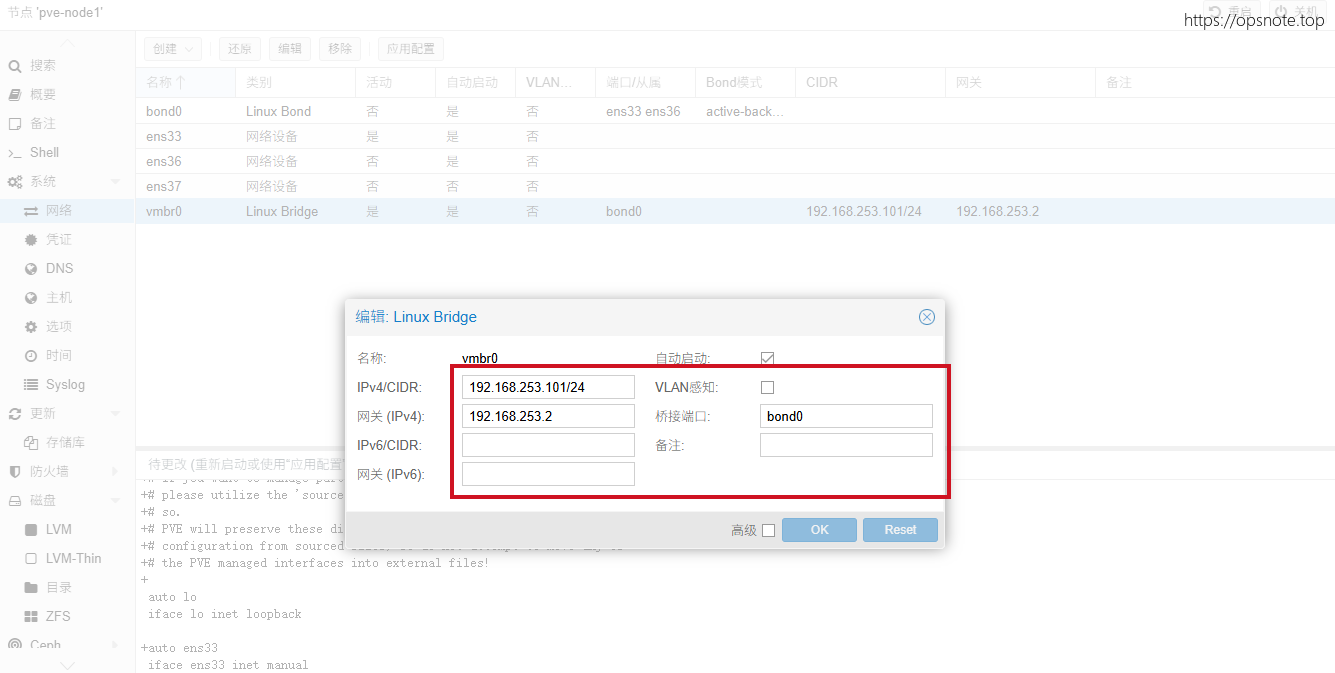

3. 配置管理网络和业务网络

创建Linux Bridge,新建vmbr0虚拟网络桥接bond0网卡,作为管理网络和业务网络,注意配置上刚才网卡的IP和网关,检查没问题后“应用配置”

管理网络: 用于运维人员使用web进行管理

业务网络: 用于业务访问

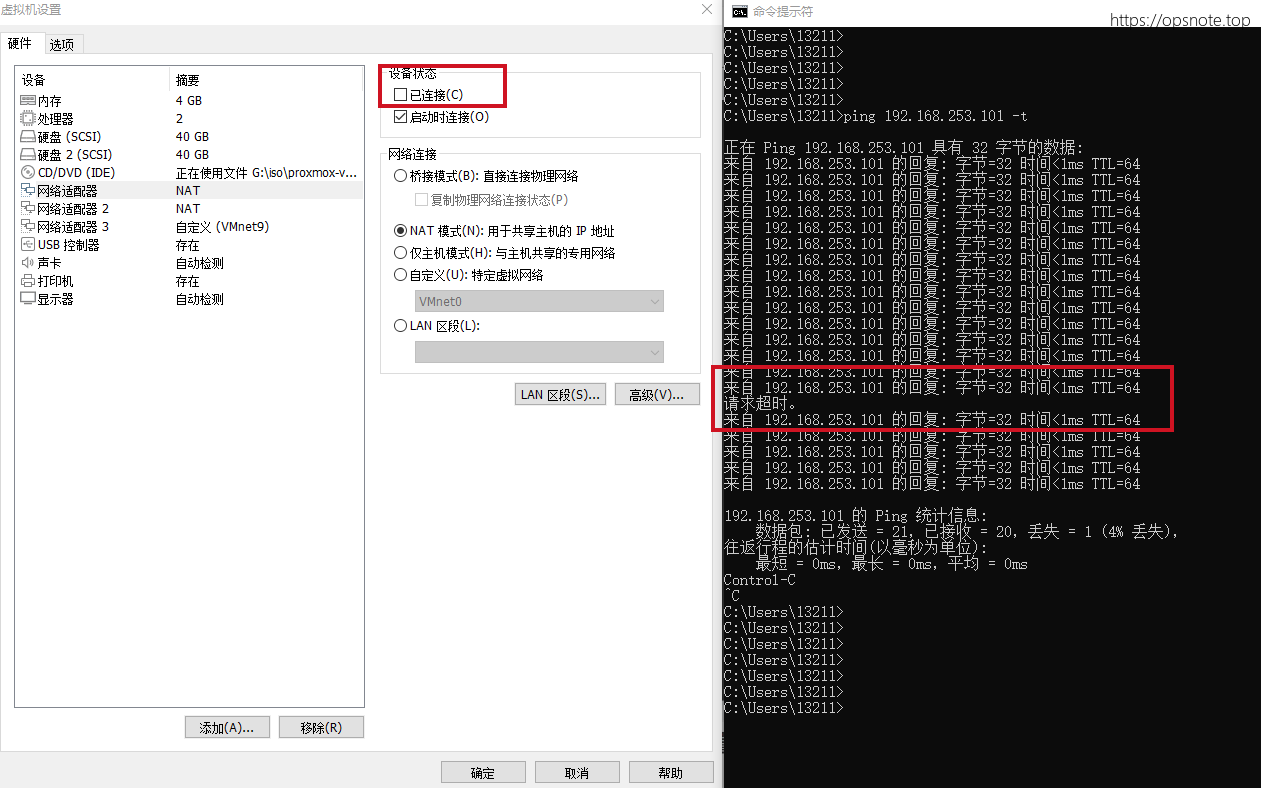

4. 网卡故障测试

关闭ens33网卡连接模拟网卡故障。active网卡发生故障网络时,在非常短暂的网络中断后,backup网卡接替工作。

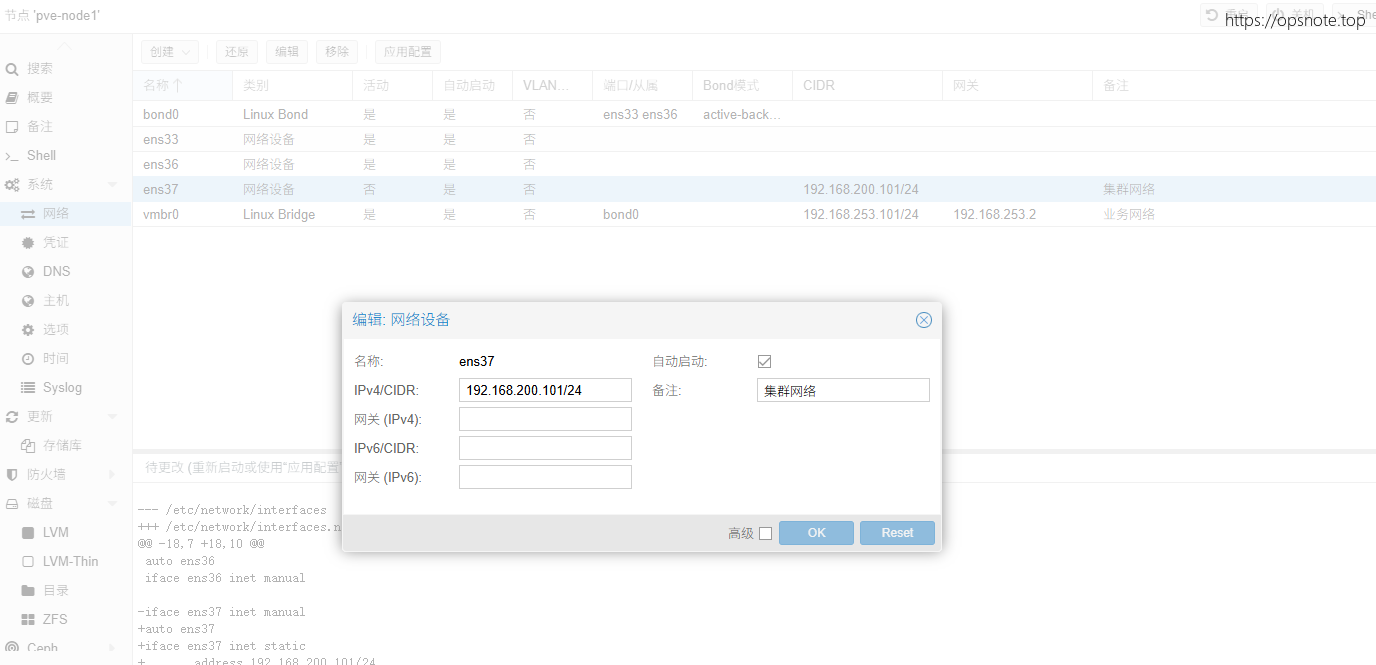

5. 创建集群网络

编辑ens37网卡,ens37网络模式为直通,使用192.168.200.0/24专属网段,作为集群网络,当虚拟机发生迁移时,优先使用该网络进行迁移,防止影响到正常业务网络。创建后注意“应用配置”

集群网络: 用于虚拟机迁移数据及ceph public_network,流量突发占用较大

微信

微信

支付宝

支付宝