PVE虚拟化平台(3)Proxmox VE 集群及ceph配置

前言

在部署集群/ceph时使用网络(ens37)作为故障转移专属网络,与管理网络、业务网络隔离。虚拟机迁移或者故障恢复优先使用故障转移专属网络,在虚拟机迁移或者故障恢复的过程中会传输大量数据,占用网络大量带宽,与业务网络共同使用会导致业务网络缓慢、卡顿等问题。

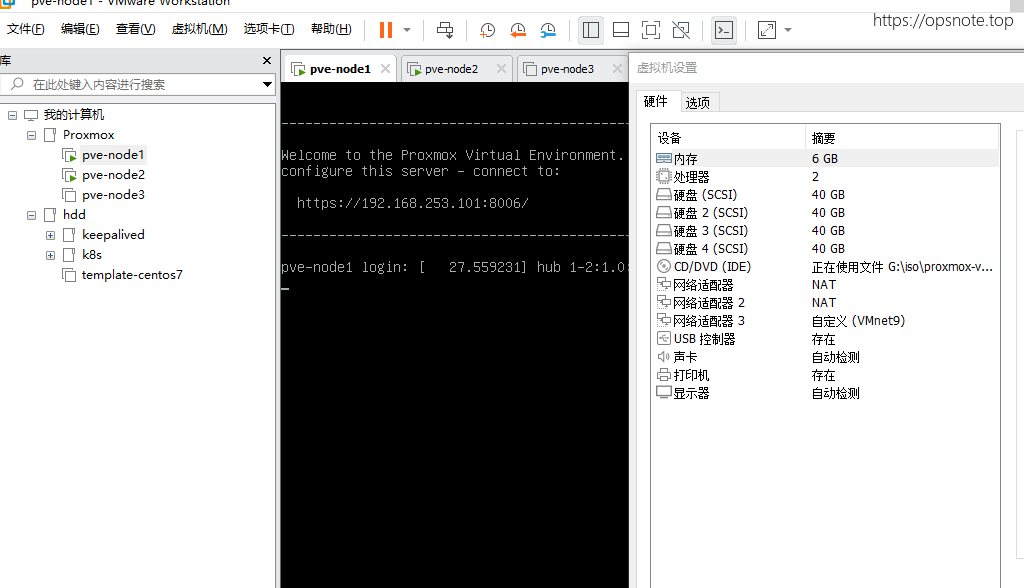

1. 磁盘添加

给各个节点添加2块磁盘,现在每个节点4块磁盘,2块组成raid1用于系统盘使用,2块用于加入ceph集群

2. 集群配置

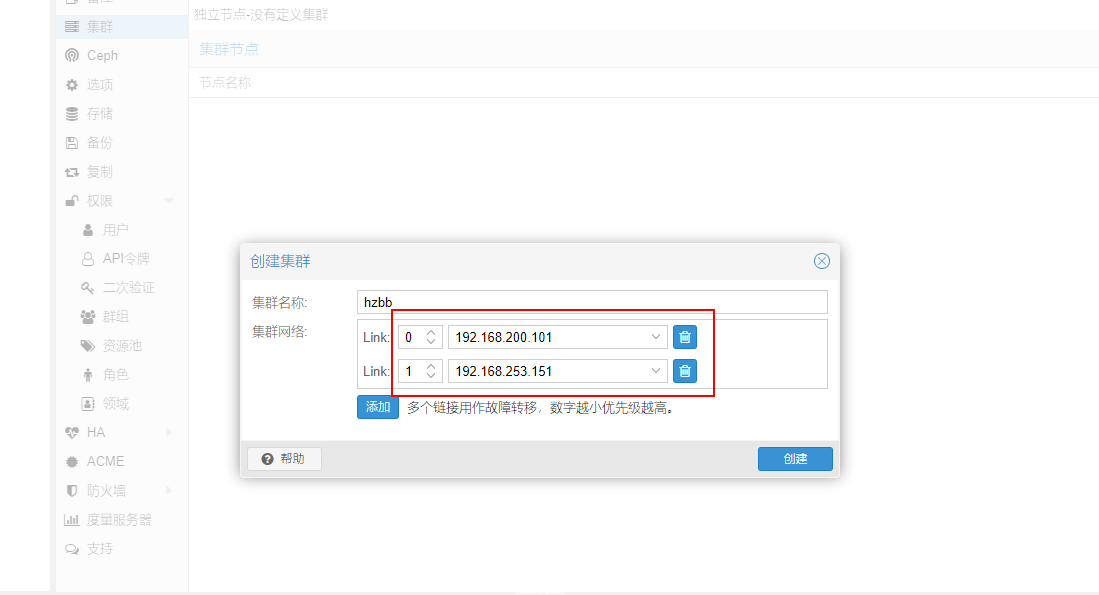

2.1 创建集群

集群网络选择刚刚创建的故障转移专属网络为第一优先级,优先使用故障转移专属网络,如果故障转移专属网络与节点同时故障,则采用管理网络传输恢复数据,保障业务可用性。

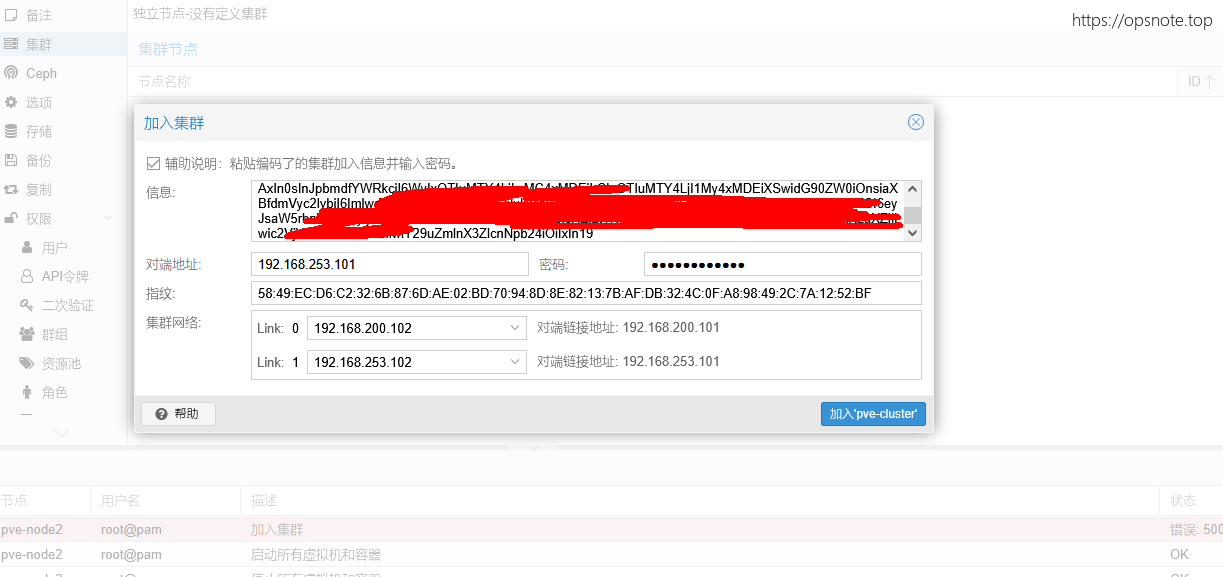

2.2 在各个节点上加入集群

各个节点加入集群时也要注意指定故障转移专属网络为第一优先级

3. Ceph配置

3.1 在节点上安装Ceph

选择Ceph部署版本16.2

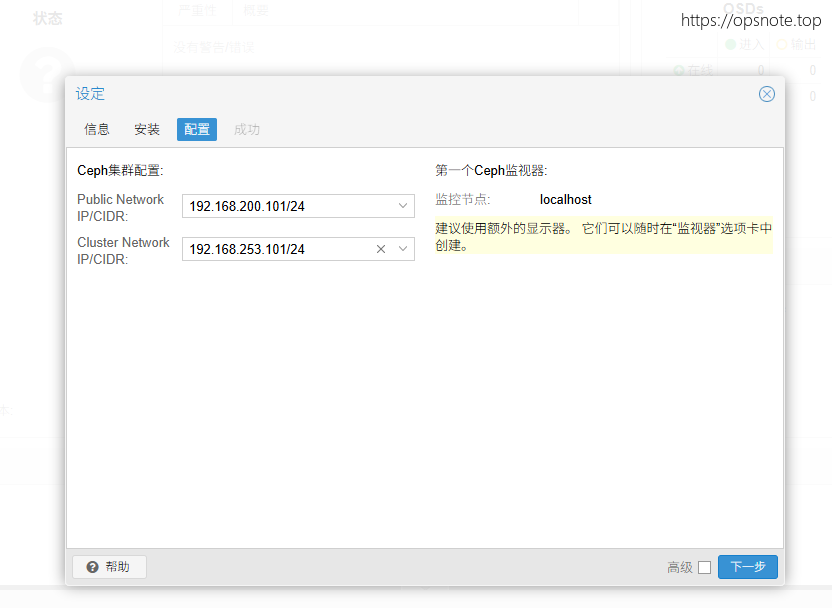

3.2 网络模式配置

public网络与Cluster网络隔开,防止ceph传输数据影响到业务网络

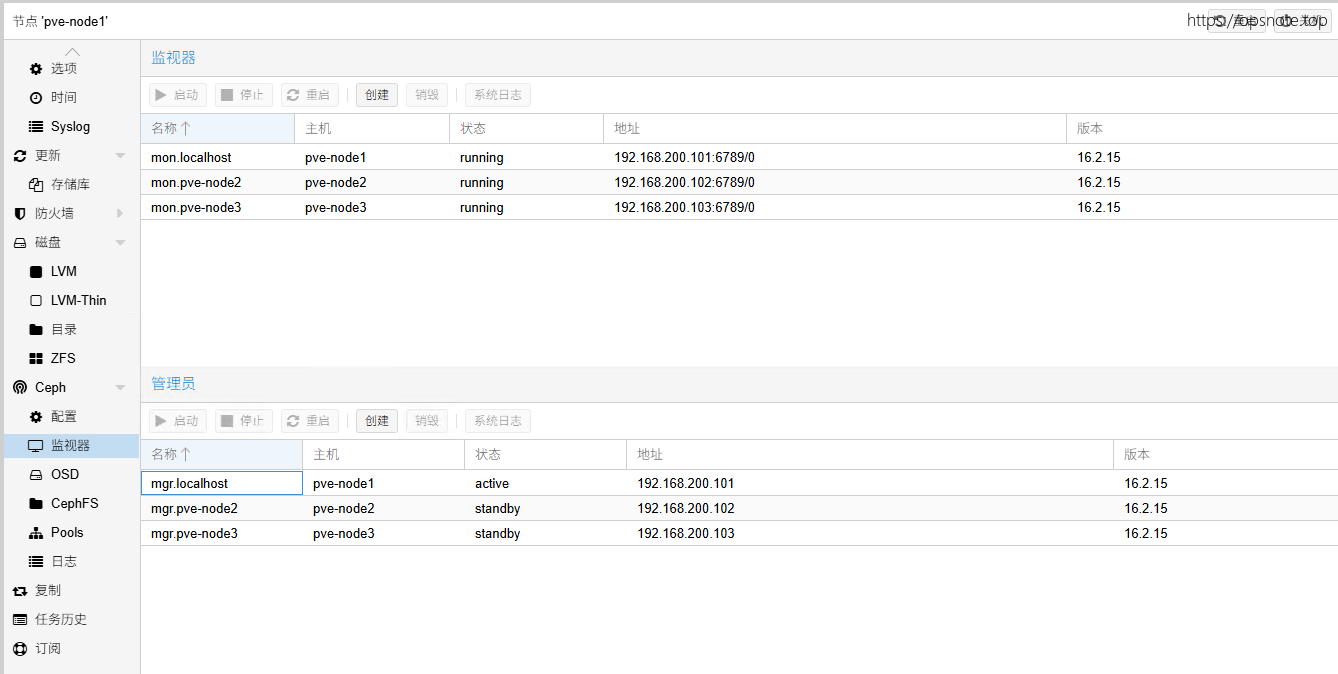

3.3 创建ceph监视器和管理器

ceph监视器: 用于监视各个节点的Ceph状态,Ceph监视器最少3个,管理员与监视器共同运行

Ceph管理器: 当ceph监视器监测到Ceph当前状态异常时,正常状态的管理员变为活跃状态负责管理Ceph。管理员只有一个为活跃状态,剩余的为空闲状态。

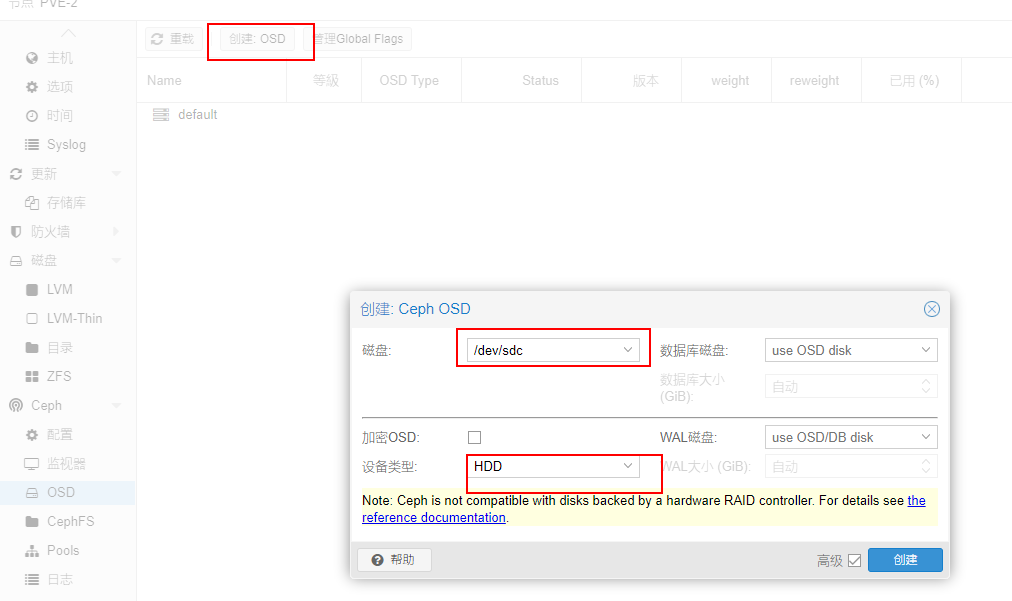

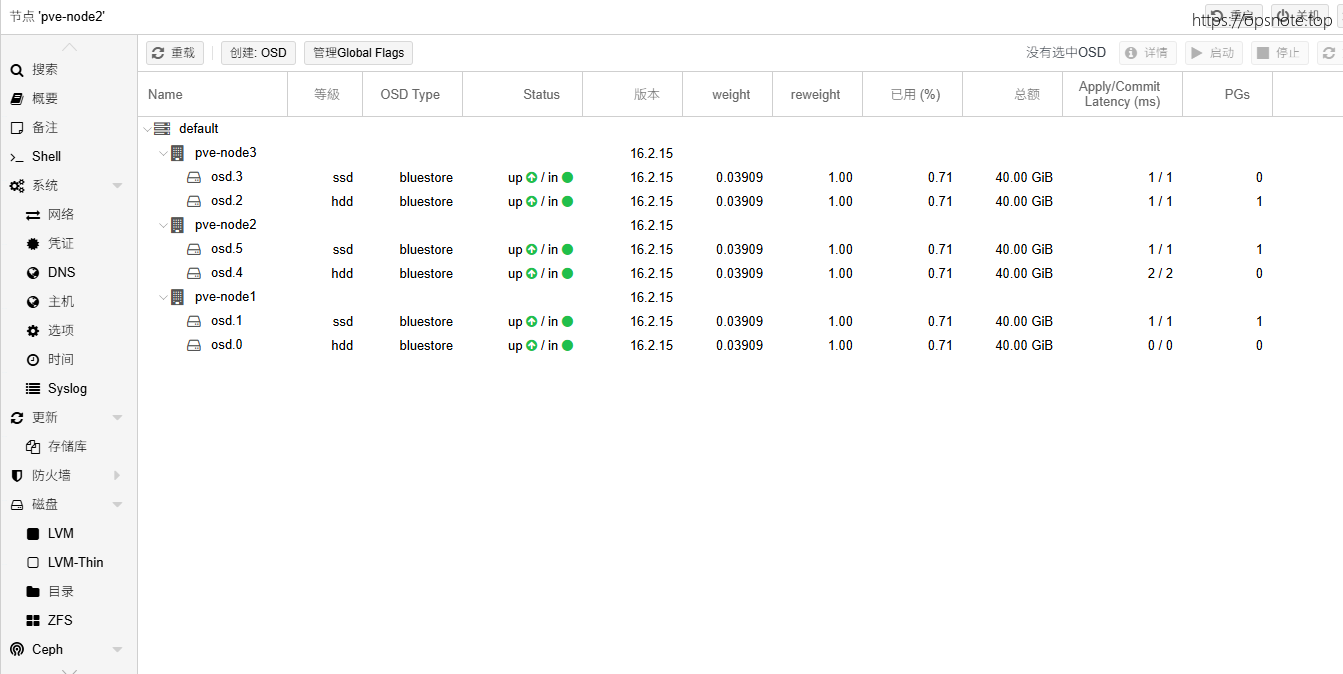

3.4 创建OSD

模拟环境分别创建hdd类型和ssd类型,用于区别不同使用场景下使用不同类型的磁盘

3.5 创建磁盘类型规则

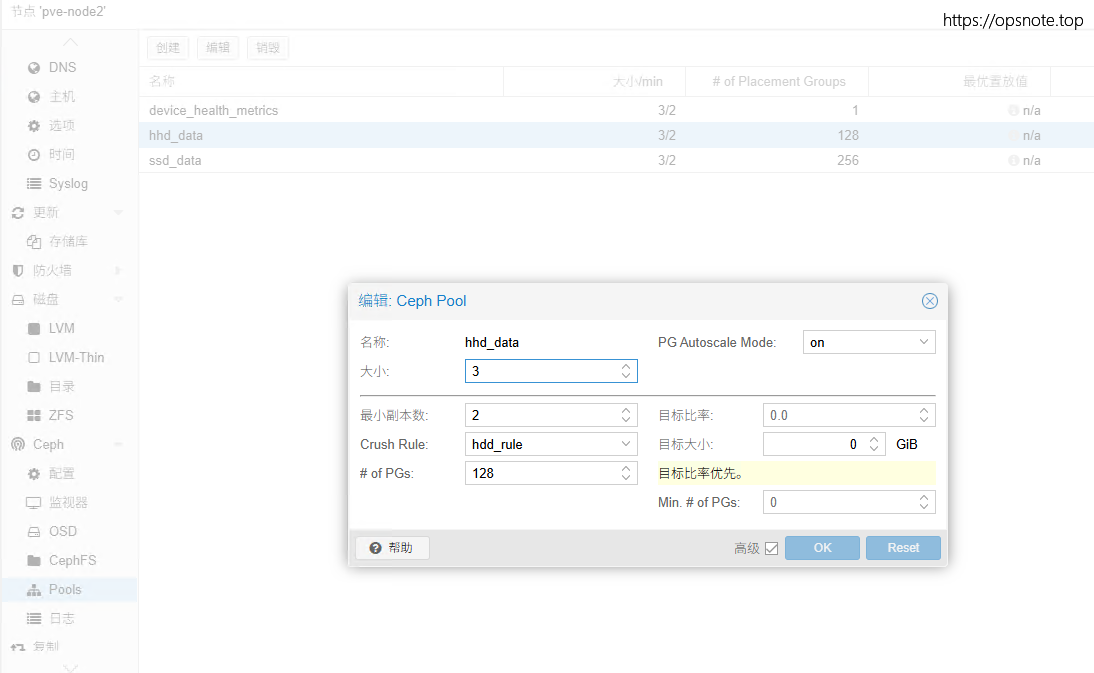

创建基于硬盘类型的规则(hdd_rule和ssd_rule),将hdd类型的硬盘与ssd类型的硬盘区分,hdd用于存储普通数据,ssd存储有高速读写需求的数据

$ ceph osd crush rule create-replicated hdd_rule default host hdd

$ ceph osd crush rule create-replicated ssd_rule default host ssd

3.6 创建基于磁盘类型规则的Pool

生产环境下建议使用 PG计算器 算出合适的pg值,以保障数据分布的均衡性和集群稳定性。

3.7 验证

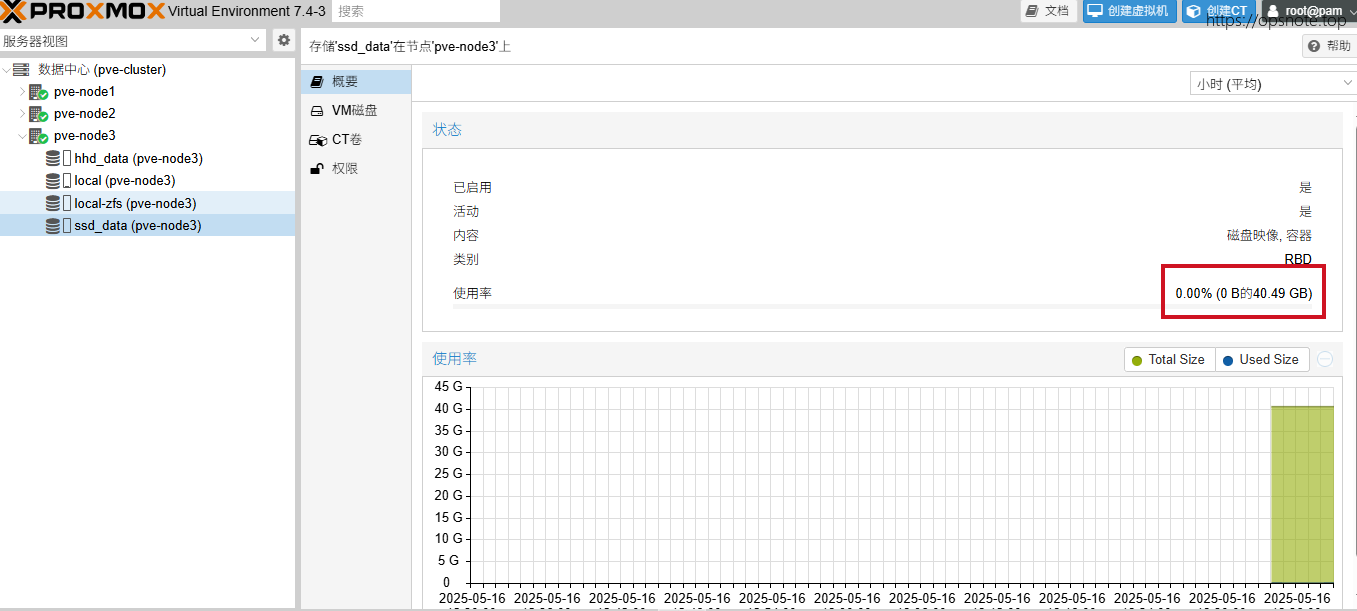

size我们设置为3,数据默认会复制3份每份存储在不同主机的OSD上,所以ssd_data和hdd_data可用容量为40G

版权声明:

本站所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自

运维小记 | 专注运维技术分享!

喜欢就支持一下吧

打赏

微信

微信

支付宝

支付宝

微信

微信

支付宝

支付宝