突破公网限制!零门槛本地部署DeepSeek大模型指南

前言

DeepSeek的强大相信亲身体验过的小伙伴都直呼NB,但因为使用人数过多又或境外攻击的原因,想要顺畅使用却很难,在这里出一篇使用自己电脑部署DeepSeek的教程,个人电脑由于配置有限只能部署1.5b蒸馏版本作为演示,自己可根据电脑硬件配置部署想要的参数量,官方的为671b满血版本。

安装步骤

1. 安装Ollama

curl https://ollama.ai/install.sh | sh

需要魔法

2. 启动Ollama服务

ollama serve

3. 拉取DeepSeek模型

ollama pull deepseek-r1:1.5b

需要魔法

运行模型需要的配置参考如下:

- deepseek 1.5b

参数量:约10亿分之-(通常理解为1,500 million或1.5亿)

硬件要求:中等性能,适用于个人用户。需要中型GPU如NVIDIA Quadr0 RTX 4000,内存需求约16GB,运行时间几个小时到一天。 - deepseek7b和8b

参数量:约70亿和80亿。

硬件要求:需稍高配置,如32GB内存,NVIDIA A100或T4系列GPU,运行时间较长。 - deepseek 14b

参数量:约140亿。

硬件要求:更高性能,如64GB内存和A40级显卡,需更长的计算时间。 - deepseek 32b

参数量:约320亿。

硬件要求:需更高配置,如80GB内存、A100或H100 GPU,适合企业级使用 - deepseek70b和671b

参数量:分别约700亿和6,710亿。

硬件要求:需超级计算机配置,包括大量显存、高性能GPU和强大处理器,通常需分布式计算。

总结: 参数越大,硬件需求越强,尤其是GPU性能、内存容量和计算时间。个人用户适合较小的模型(如7b或8b),而更大的模型需要企业级资源。

4. 配置Ollama远程访问

vim /etc/systemd/system/ollama.service

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

Environment="OLLAMA_HOST=0.0.0.0:11434"

Environment="OLLAMA_ORIGINS=*"

ExecStart=/usr/local/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=/usr/local/java/jdk1.8.0_421/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/local/go/bin:/bin:/usr/local/apache-maven-3.8.8/bin"

[Install]

WantedBy=default.target

- 重启ollama

systemctl daemon-reload

systemctl restart ollama

5. 启动DeepSeek模型

ollama run deepseek-r1:1.5b

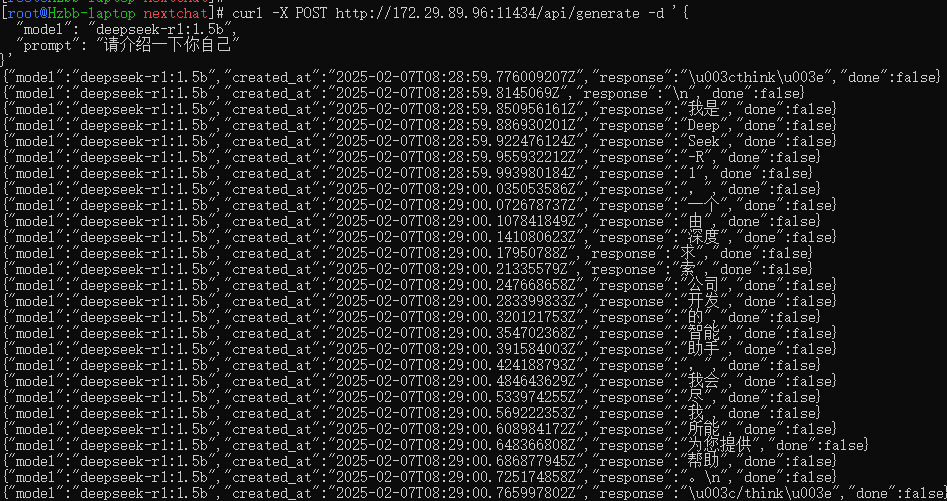

6. 调用API测试

curl -X POST http://172.29.89.96:11434/api/generate -d '{

"model": "deepseek-r1:1.5b",

"prompt": "请介绍一下你自己"

}'

- 172.29.89.96为部署大模型所在服务器的IP地址,输出以下结果即调用成功

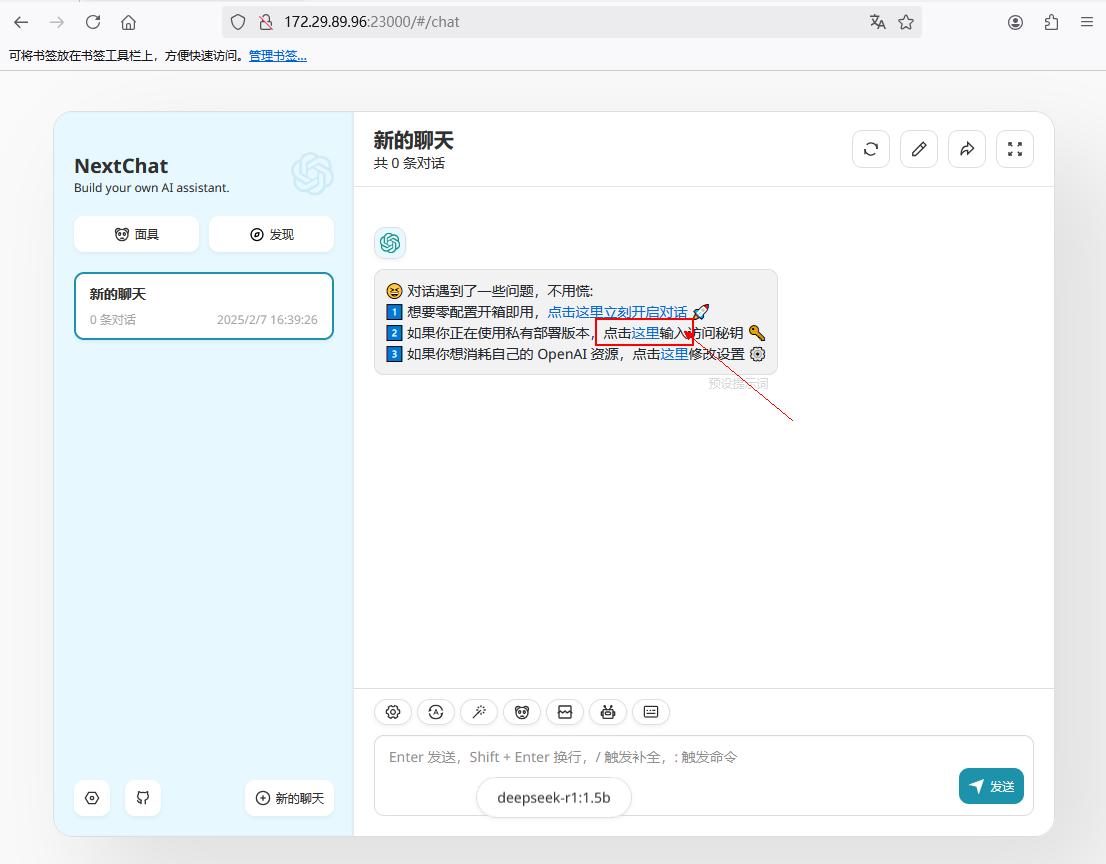

7. 安装图形化大模型对话工具 Nextchat

vim docker-compose.yml

version: '3'

services:

chatgpt-next-web:

image: registry.cn-guangzhou.aliyuncs.com/hzbb/chatgpt-next-web:v2.15.8

container_name: chatgpt-next-web

ports:

- "23000:3000"

environment:

- BASE_URL=http://172.29.89.96:11434 # 大模型服务器IP

- CUSTOM_MODELS=-all,+deepseek-r1:1.5b

- HIDE_USER_API_KEY=1

- DISABLE_GPT4=1

- CODE=hzbb

restart: always

docker-compose up -d

需提前安装Docker及Docker-compose,镜像已缓存至阿里云节点,境内可以正常拉取

8. 访问网页

这里大模型和Nextchat都部署在一台机上,访问地址为:http://172.29.89.96:23000 ,首次使用需输入密码 hzbb

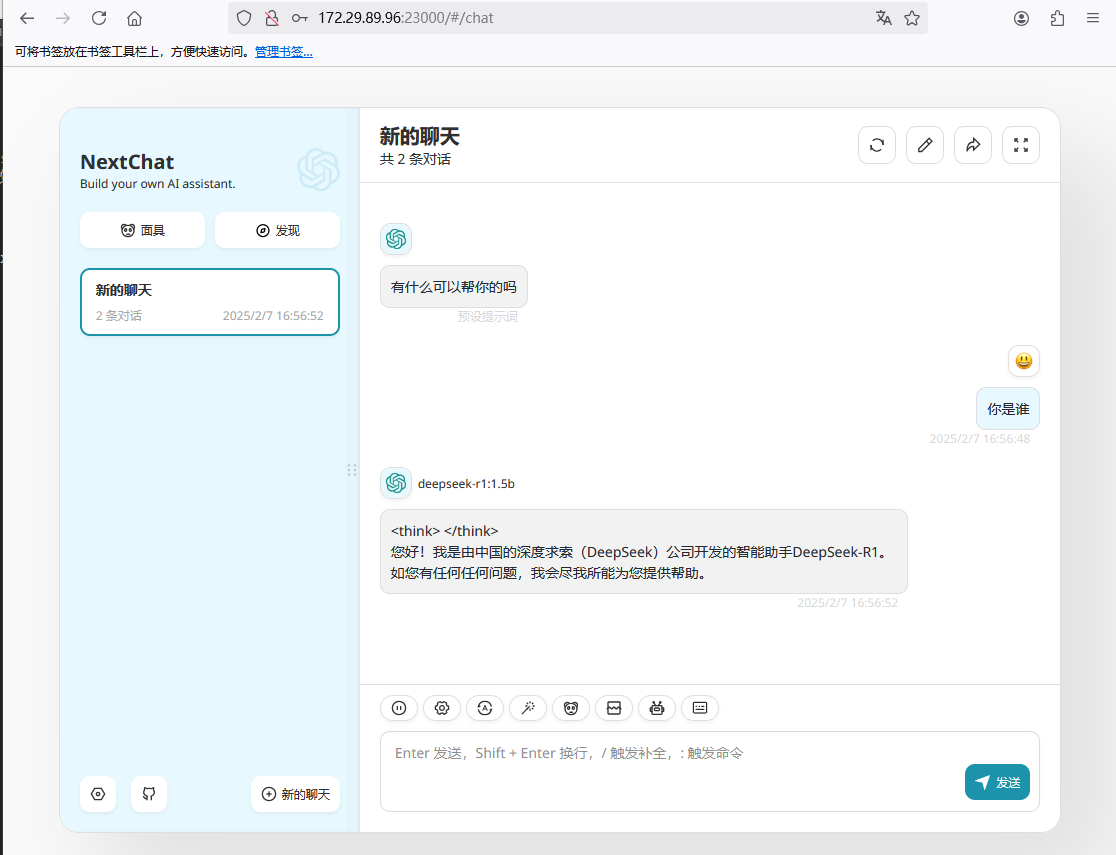

9. 使用测试

版权声明:

本站所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自

运维小记 | 专注运维技术分享!

喜欢就支持一下吧

打赏

微信

微信

支付宝

支付宝

微信

微信

支付宝

支付宝